首页>博客>行业科普>知识图谱、大模型与幻觉:自然语言处理的视角

知识图谱、大模型与幻觉:自然语言处理的视角

大型语言模型(LLMs)已经彻底改变了基于自然语言处理(NLP)的应用,包括自动化文本生成、问答系统、聊天机器人等。然而,它们面临一个重大挑战:产生幻觉,即模型生成听起来合理但实际上错误的内容。这削弱了信任,并限制了LLMs在不同领域的适用性。另一方面,知识图谱(KGs)提供了结构化的互联事实集合,以实体(节点)及其关系(边)表示。在最近的研究中,KGs已被用于提供上下文,可以填补LLMs在理解某些话题时的空白,提供了一种缓解LLMs幻觉的有前途的方法,增强了它们的可靠性和准确性,同时受益于它们广泛的适用性。尽管如此,它仍然是一个非常活跃的研究领域,存在许多未解决的开放性问题。在本文中,我们讨论了这些未解决的挑战,涵盖了最新的数据集和基准测试,以及知识整合和评估幻觉的方法。在我们的讨论中,我们考虑了当前大型语言模型(LLMs)在LLM系统中的使用,并针对每个挑战确定了未来的方向。

研究背景

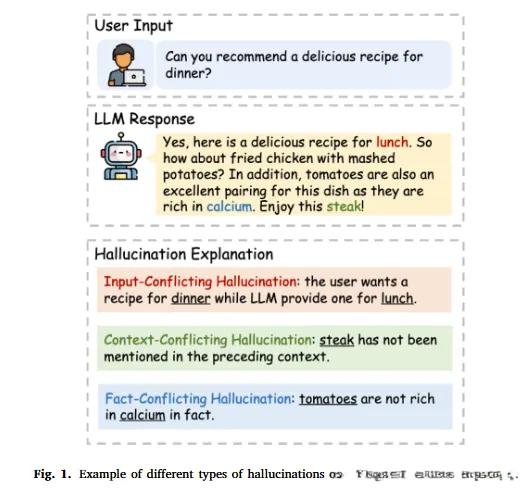

1.研究问题:这篇文章要解决的问题是大型语言模型(LLMs)在生成文本时容易出现的事实不一致现象,即“幻觉”。这种幻觉会损害用户对AI系统的信任,并在某些情况下生成误导性信息。 2.研究难点:该问题的研究难点包括:幻觉的多面性(如世界知识、自相矛盾、与提示指令或给定上下文的幻觉)、评估幻觉的复杂性(需要评估输出的语义一致性)以及现有数据集和基准测试的局限性。

3.相关工作:该问题的研究相关工作有:利用知识图谱(KGs)提供结构化的事实信息来缓解LLMs的幻觉问题、现有的幻觉检测方法和知识整合模型。

研究方法

这篇论文提出了利用知识图谱(KGs)来缓解LLMs的幻觉问题。具体来说,

1.知识图谱的利用:KGs是一种结构化的知识表示形式,由实体(节点)和它们之间的关系(边)组成。通过将KGs的信息整合到LLMs中,可以在推理或生成过程中提供事实基础,从而提高输出的一致性和准确性。

2.知识整合模型的分类:根据其底层架构,可以将不同的知识整合模型进行分类。论文提出了一个分类框架,展示了在不同阶段加入额外信息以增强事实性的可能性。

3.幻觉检测方法:GraphEval提出了一种两阶段的幻觉检测和缓解方法,通过从LLMs输出中提取原子断言并与给定文本上下文进行比较来进行检测。其他方法如KGR、Fleek等也采用了类似的方法,但都存在一些局限性。

4.多提示评估:DefAn数据集通过为每个问答数据点提供15个不同的问题重述,来评估LLMs的鲁棒性和一致性。

实验设计

1.数据集:论文评估了多个幻觉检测和数据集,包括Shroom SemEval 2024、MuShroom SemEval 2025、MedHalt、HaluEval、TruthfulQA、FELM、HaluBench、DefAn、SimpleQA等。这些数据集覆盖了多个领域和任务类型,如法律、政治、医学、科技、艺术、金融等。

2.评估指标:使用了多种评估指标,如准确率、校准、F1值等,来评估幻觉检测模型的性能。对于知识整合方法,还使用了BERTScore和BARTScore等语义相似度度量。

3.实验设置:实验设置包括对每个数据集的划分(训练、验证、测试)、子任务的定义以及外部知识的来源(如文本上下文、网页等)。

结果与分析

1.幻觉检测效果:现有的幻觉检测方法在识别和处理幻觉方面取得了一定的进展,但仍存在一些问题。例如,多阶段管道方法的鲁棒性和可扩展性有限,且高度依赖于LLMs的提示。

2.知识整合效果:通过将KGs信息整合到LLMs中,可以显著提高输出的一致性和准确性。然而,现有的知识整合方法在快速知识更新和避免提示脆弱性方面仍存在挑战。

3.多提示评估:DefAn数据集的评估结果表明,多提示方法可以提高LLMs的鲁棒性和一致性,但仍需要进一步的研究来验证其在不同场景下的有效性。

总结结论

这篇论文总结了利用知识图谱(KGs)来缓解LLMs幻觉问题的现状和挑战。尽管已有方法取得了一定的进展,但幻觉缓解仍然是一个持续的研究问题。论文提出了未来研究的方向,包括大规模数据集、多语言和多任务的评估、细粒度的幻觉检测、减少对文本提示的依赖以及混合使用不同的幻觉缓解方法。通过这些研究方向,论文希望为LLMs的幻觉问题提供更有效的解决方案。